Как ИИ меняет рынок наушников и колонок

Мы независимо проверяем товары и технологии которые рекомендуем.

1. Встроенные переводчики в наушниках

После презентации AirPods Pro 3 в сети постоянно мелькали отсылки к универсальному переводчику из сериала Star Trek, который мгновенно переводит инопланетные языки для членов экипажа Звездного Флота, позволяя им понимать друг друга, не начиная знакомство со стрельбы и рукопашки. В рекламе Apple показала что-то похожее, но без инопланетян: AirPods Pro 3 используют продвинутые алгоритмы машинного обучения сначала для распознавания речи, затем моментального перевода и генерации речи на нужный язык. Выглядит это как крайне интересная штука для путешествий и деловых командировок, с единственной оговоркой, что их переводчик пока понимает 5 языков и работает лишь на последних поколениях iPhone с поддержкой Apple Intelligence. У Google успехи пока тоже не супер, качественный синхронный перевод обещали еще в 2018 году во всех наушниках с ассистентом Google, но все до сих пор работает криво со множеством ограничений и недоговорок. Поэтому для синхронного перевода лучше подходят специализированные решения в духе Timekettle W4 Pro и Vasco Translator E1.

2. Интеграция с LLM‑ассистентами

Если раньше умные колонки могли разве что включить музыку или рассказать прогноз погоды, то теперь они готовы стать полноценными собеседниками. Традиционные голосовые помощники выглядят довольно примитивно по сравнению с современными LLM ― да, они умеют отвечать на базовые вопросы и управлять умным домом, но на этом их таланты заканчиваются. А вот интеграция ChatGPT, Gemini и других продвинутых языковых моделей меняет игру кардинально. Google уже анонсировал планы по интеграции Gemini в наушники и часы, позволяя пользователям вести полноценный диалог с ИИ прямо через наушники командой «Окей, Google». А стартап Nothing добавляет в свои наушники поддержку ChatGPT. Из более нишевых примеров стоит отметить необычные наушники ikko ActiveBuds со встроенным LLM ChatPal (построен на основе ChatGPT), которые могут не только переводить, но и вести осмысленную беседу, помочь с работой или пересказать новости.

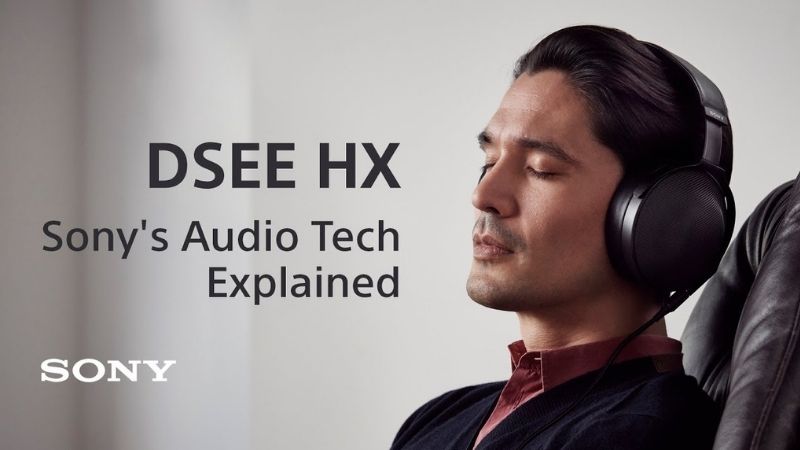

3. ИИ‑апскейлинг аудио

Помните времена, когда переход с кассет на CD казался революцией? Теперь ИИ делает нечто подобное, но в обратную сторону: алгоритмы вроде Sony DSEE Extreme и Samsung UHQ Upscaler прогнозируют гармоники, добавляют недостающие нюансы, корректируют шумы и искусственно увеличивают битрейт записи. Получается эдакий искусственный ремастеринг, который может оживить старую джазовую или оркестровую запись, расширив стерео-сцену и повысив читаемость индивидуальных инструментов. Фактически это аналог функции ИИ-апскейлинга в Photoshop и других редакторах, которая повышает четкость изображения в плохом качестве, но для музыки.

4. Адаптивное шумоподавление

Если раньше ANC просто «глушило все подряд», то новые штуки типа Adaptive Audio в AirPods Pro и AI ANC у Bose и Sony способны различать окружающие звуки и реагировать на них по-разному. Алгоритмы понимают разницу между гулом самолета, громким разговором по соседству или шумом ветра, и в реальном времени подстраивают фильтры. При этом учитывается даже посадка наушников: датчики проверяют плотность амбушюров, а акселерометры отслеживают движение и если к примеру, вы едете на велосипеде, то умный ANC может подавлять шум ветра, сохраняя разборчивость других звуков вроде автомобильного гудка или сирены скорой помощи.

5. Автоподстройка эквалайзера

Раньше настройка эквалайзера была уделом продвинутых аудиофилов, которые часами крутили ползунки частот в поисках идеального звучания. Теперь наушники делают это сами и, причем довольно успешно, так как ИИ учитывает не только ваши предпочтения, но и физиологические особенности слуха. К примеру, австралийская Nura произвела настоящую революцию с технологией, которая измеряет уникальное строение вашего слуха за 60 секунд. Наушники посылают звуковые импульсы и анализируют отклик ушной улитки — по сути, создают персональную карту вашего слуха. Из более приземленных примеров в голову приходит функция Find My Equalizer в Sony WF-1000XM5. Вы просто говорите приложению, какой звук хотите, и оно генерирует подходящие настройки кривой эквалайзера. А в Bose QuietComfort Ultra с помощью функции CustomTune звук можно автоматически подстроить под форму ушей. И таких примеров все больше и больше.

6. Анализ активности пользователя

изменять громкость и облегчать восприятие голосов.

Современные наушники с ИИ умеют подстраивать звук исходя из активности пользователя и его окружения. К примеру, акселерометр может фиксировать, идете ли вы пешком, едете на велосипеде или сидите за компьютером, а данные от GPS и Wi‑Fi с подключенного смартфона помогают определить местоположение. Затем на основе полученной информации ИИ-оптимизатор настраивает звук и уровень шумоподавления. Например, в Sony WH-1000XM5 фича Adaptive Sound Control используется для автоматической смены настроек в зависимости от локации и типа активности, Apple AirPods Pro 2 с помощью Adaptive Audio подстраивают звук под окружение в реальном времени, а Bose QuietComfort Ultra Earbuds 2 могут усиливать шумоподавление, если вы летите в самолете или едете в поезде.

7. Мониторинг физических показателей с помощью звука

Благодаря наличию дополнительных сенсоров и процессоров современные наушники постепенно превращаются в персональные медицинские устройства, способные анализировать здоровье владельца с помощью самых разных физических показателей. Сенсоры и алгоритмы ИИ умеют отслеживать паттерны дыхания во время сна, замечать изменения в голосе, сигнализирующие о простуде, стрессе или уровне усталости, мониторить сердечный ритм через ушной канал или изучать походку по акустическим данным шагов, выявляя усталость или проблемы с балансом. Некоторые стартапы, например Ellipsis Health, разрабатывают технологии анализа психического состояния по голосу, а во время пандемии исследователи из MIT тестировали технологию выявления COVID-19 по звукам кашля. Впрочем, в большинстве своей это скорее исследовательские проекты и скорее всего большинство из них не дойдет до массового производства.

8. Пространственный звук с отслеживанием головы

Пространственный звук стал одной из ключевых функций современных наушников. К примеру в последних моделях AirPods Pro используется технология Spatial Audio, которая работает в связке с сенсорами для отслеживания движений головы. У Sony и Streamsoft есть похожая наработка под названием 360 Reality Audio. На практике результаты неоднозначные. Иногда эффект действительно впечатляет — особенно в фильмах и играх. Но чаще всего это скорее демонстрация технологий, чем реально полезная функция. Основная проблема в том, что большинство музыки и подкастов изначально не рассчитаны на пространственное воспроизведение, поэтому искусственное «размазывание» стерео по виртуальным динамикам часто звучит неестественно.

9. Upmixing и виртуализация многоканального звука

Апмиксинг (upmixing) — это процесс преобразования стереосигнала в искусственный многоканальный формат 5.1 или 7.1. Проще говоря, на саундбаре или в наушниках создается иллюзия пространственного звучания. Сегодня эта технология основана в первую очередь на цифровой обработке сигнала (DSP): фильтры, задержки и фазовые сдвиги формируют ощущение, будто звук исходит из разных точек комнаты. Например, в саундбарах Sennheiser AMBEO используются алгоритмы от Fraunhofer upHear Immersive Audio Virtualizer, которые превращают стерео или 5.1 в объемный 3D-звук без нужды в тыловых колонках. Sony использует похожий подход в системе 360 Upmix, которая обрабатывает любой контент в реальном времени, от старых MP3 до потоковой музыки.

10. Автокалибровка колонок под помещение

Раньше настройка акустики превращалась в испытание. Владельцам приходилось часами возиться с микрофоном и специальным софтом, пуская по комнате синусоиды и вручную корректируя эквалайзер. Сегодня процесс заметно упростился: встроенные алгоритмы обработки звука берут на себя большую часть рутинной работы, автоматически подстраивая звучание под особенности помещения. К примеру, самые новые смарт-колонки Sonos с помощью алгоритмов Trueplay и встроенных микрофонов автоматически адаптируют звук под акустику комнаты. Dirac Live работает еще глубже и умеет анализировать реверберации в помещении, а затем отделяет полезный сигнал от шумов и корректирует не только АЧХ, но и фазу. Ну а Bang & Olufsen научили свои смарт-колонки Beosound Balance в реальном времени анализировать акустику пространства и автоматически корректировать звук в зависимости от ситуации.

11. Вывод

ИИ в аудиотехнике пока проходит стадию экспериментов ― наверняка какие-то из представленных выше примеров не приживутся на рынке, а какие-то наоборот станут стандартом. В целом, в отличие от многих других отраслей, использование ИИ в аудиотехнике показывает, что новые технологии уже способны не только удивлять, но и действительно улучшать звучание и удобство использования.

Cтатьи, обзоры, полезные советы

Все материалы